Pewnego dnia zastanawiałem się: „Dlaczego są pliki RAW z mojego aparatu?” Nikon D700 tak mało ważą?'. Szukając odpowiedzi, znalazłem kilka bardzo interesujących informacji.

O sztuce pikselowej

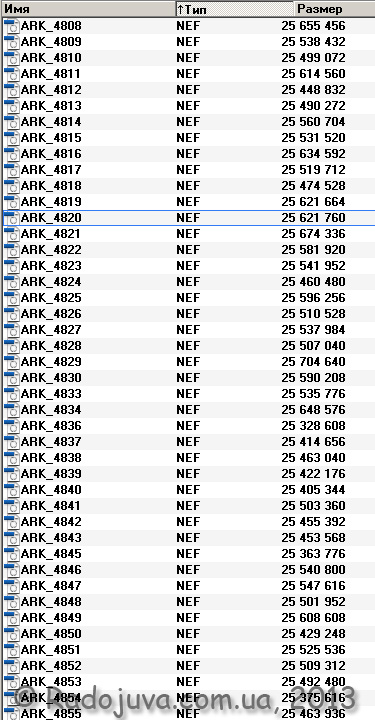

Dlatego podczas fotografowania czasami używam formatu plików RAW (Nikon nazywa go NEF – Nikon Electronic Format – elektroniczny format plików firmy Nikon). Pliki RAW firmy Nikon mieć pewne ustawienia, zwykle używam 14-bitowej głębi kolorów z bezstratną lub bez kompresji. Ogólnie 14-bitowe nieskompresowane pliki NEF ważą około 24.4 MB. Na poniższym obrazku pokazałem rozmiary moich plików w bajtach.

Rozmiary plików NEF w moim aparacie Nikon D700

Jak widać, pliki mają prawie ten sam rozmiar. Weźmy na przykład plik ARK-4820.NEF, jego waga to 25 621 760 bajtów, czyli 24,4 MB. Bajty na megabajty są tłumaczone w bardzo prosty sposób:

25 624 760 / 1 048 576 = 24,4

Pragnę zwrócić uwagę na fakt, że różna waga plików RAW (NEF) wynika z faktu, że zawierają one nie tylko przydatne „surowe” informacje, ale także mały obrazek podglądu, a także EXIF moduł danych. Obraz podglądu służy do szybkiego podglądu obrazu na monitorze aparatu. Aparat nie wymaga pobierania dużego 25 MB pliku podczas szybkiego przeglądania, ale po prostu wyjmuje miniaturę i pokazuje ją na swoim wyświetlaczu. Te zdjęcia są najprawdopodobniej zakodowane przy użyciu JPEG, a algorytm JPEG jest bardzo elastyczny i wymaga innej ilości informacji do przechowywania dla każdej miniatury.

14-bitowa głębia kolorów oznacza, że każdy z trzech podstawowych odcienie zakodowany z 14 bitami pamięci. Na przykład po kliknięciu przycisku „znak zapytania” w odpowiedniej pozycji menu aparatu Nikon D700 możesz przeczytać następujące informacje:

Obrazy NEF (RAW) są rejestrowane z 14-bitową głębią kolorów (16384 poziomy). Jednocześnie pliki są większe i dokładniejsze odwzorowanie odcieni”

Kolor powstaje poprzez zmieszanie trzech podstawowych odcieni - czerwonego R (czerwonego), niebieskiego B (niebieskiego), zielonego G (zielonego). Tak więc, jeśli użyjemy 14-bitowej głębi kolorów, możemy uzyskać dowolny z 4 398 046 511 104 kolorów. (dowolny z czterech miliardów trzysta dziewięćdziesiąt osiem miliardów czterdzieści sześć milionów pięćset jedenaście tysięcy sto cztery kolory).

Łatwo policzyć: 16384 (R) * 16384 (G) * 16384 (B)

W rzeczywistości 4 miliardy to znacznie więcej niż potrzeba do normalnego odwzorowania kolorów, wykorzystywana jest tak duża podaż kolorów do łatwej edycji obrazu. A żeby w ten sposób zakodować jeden „piksel” obrazu, potrzeba 42 bity pamięci:

14 bitów R + 14 bitów G + 14 bitów B = 42 bity

Мой Nikon D700 tworzy obrazy o maksymalnej jakości 4256 na 2832 pikseli, co daje dokładnie 12 052 992 piksele (około 12 milionów pikseli, czyli po prostu 12 MP). Jeśli kodujesz obrazy z my Nikon D700, bez użycia algorytmów kompresji i kompresji danych, a przy 14-bitowej głębi kolorów okazuje się, że trzeba użyć 506 225 664 bitów informacji (42 bity / piksel razy 12 052 992 piksele). Odpowiada to 63 278 208 bajtom lub 60,3 MB pamięci.

Pytanie: dlaczego oblicza się, że na jeden obraz potrzeba około 60 MB pamięci, a w rzeczywistości otrzymuję pliki o wielkości 24.4 MB? Sekret tkwi w tym, że oryginalny plik RAW nie przechowuje „prawdziwych” pikseli, ale informacje o subpikselach matrycy CMOS Nikon D700.

W opisie aparatu można znaleźć:

Fragment z instrukcji do Nikona D700

Oznacza to, że instrukcje mówią o „efektywnych pikselach” i o „całkowitej liczbie” pikseli. Liczba efektywnych pikseli jest bardzo łatwa do obliczenia, wystarczy zrobić zdjęcie w trybie JPEG L Fine i uzyskać zdjęcie o wymiarach 4256 na 2832 pikseli, co odpowiada wcześniej opisanym 12 052 992 pikselom. Jeśli zaokrąglimy w górę, otrzymamy 12.1 MP zadeklarowane w instrukcji. Ale czym jest ta „całkowita liczba pikseli”, których jest o prawie milion (1 MP) więcej (12,87 MP)?

Aby to zrozumieć, wystarczy pokazać, jak wygląda światłoczuła matryca aparatu. Nikon D700.

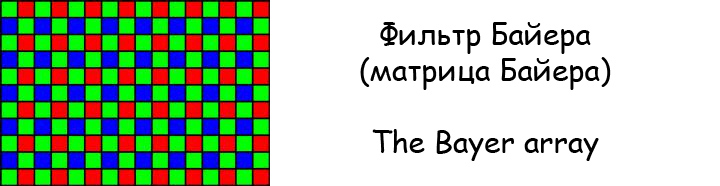

Filtr Bayera

Jeśli przyjrzysz się uważnie, matryca Bayera nie tworzy żadnego „wielokolorowego” obrazu. Matryca po prostu rejestruje zielone, czerwone i niebieskie kropki, z dwukrotnie większą liczbą zielonych kropek niż kropek czerwonych lub niebieskich.

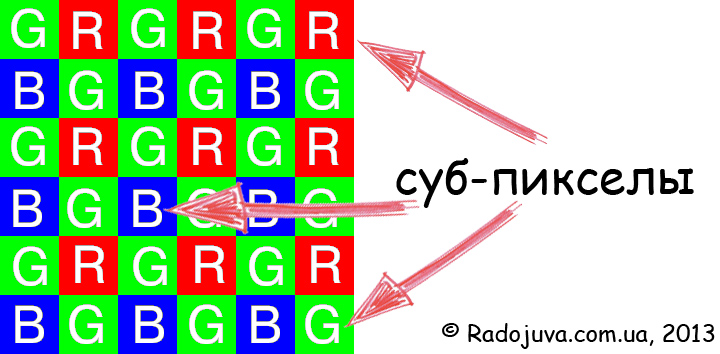

„Nieprawdziwy” piksel

W rzeczywistości ta matryca nie składa się z pikseli („w zwykłym znaczeniu”), ale z subpikseli lub komórek rejestratora. zwykle sugerowaćże piksel to punkt na obrazie reprezentujący dowolny kolor. Na czujniku CMOS Nikon D700 istnieją tylko subpiksele, które odpowiadają tylko za trzy główne odcienie, na podstawie których powstają „prawdziwe”, „wielokolorowe” piksele. Nikon D700 ma około 12 870 000 tych subpikseli, określanych w instrukcji jako „efektywne” piksele.

W matrycy Nikona D12 nie ma „prawdziwych” 700 MP. A 12 MP, które widzimy na końcowym obrazie, jest wynikiem trudnej matematycznej interpolacji subpikseli 12.87 megapiksela!

Po uśrednieniu każdy subpiksel jest konwertowany przez algorytmy na jeden rzeczywisty „piksel”. Dzieje się tak z powodu sąsiednich pikseli. Tutaj jest po prostu ukryty 'pikselowa magia ulicy„. Podobnie 4 miliardy kolorów to także praca algorytmu debayeryzacji.

Główna idea artykułu: subpiksele i piksele. Sprzedaje się nam 12 milionów subpikseli za cenę 12 milionów „prawdziwych pikseli”.

Mówiąc bardzo z grubsza, marketerzy nazwali subpiksele filtra Bayera „pikselami” iw ten sposób dokonali zamiany znaczeń słów. Wszystko jest powiązane z tym, co dokładnie musisz zrozumieć pod słowem „piksel”.

Wróćmy do obliczeń objętości plików. W rzeczywistości plik NEF przechowuje tylko 14 bitów informacji dla każdego subpiksela filtru Bayera, co w rzeczywistości jest tą samą głębią odcienia. Biorąc pod uwagę, że na matrycy znajduje się 12 870 000 takich subpikseli (liczba jest przybliżona, wskazana w instrukcji), to przechowywanie uzyskanych z nich informacji będzie wymagało:

12 870 000 * 14 bitów = 180 180 000 bitów lub 21,48 MB

A jednak w żaden sposób nie dostałem 24,4 MB, które obserwuję na swoim komputerze. Ale jeśli dodamy dane z EXIF i JPEG PreviewImage, możesz uzyskać początkowe 24,4 MB. Okazuje się, że plik RAW przechowuje również:

24,4-21,48=2,92 MB dodatkowych danych

Ważne: podobne obliczenia można wykonać dla aparatów z matrycami CCD i plików RAW bez kompresji - Nikon D1, D1h, D1x, D100, D200, a także macierze JFET (LBCAST) - Nikona D2h, D2h. W rzeczywistości nie ma różnicy Czy to CCD czy CMOS? – nadal wykorzystują filtr Bayera i subpexiles do tworzenia obrazu.

Ale aparaty Sigma z matrycami Foveon mają znacznie większy rozmiar pliku RAW dla tego samego 12 MP w porównaniu z matrycą CMOS, która koduje jeden prawdziwy piksel przy użyciu trzech pikseli kolorów podstawowych (zgodnie z oczekiwaniami), to tylko potwierdza moje rozumowanie. Nawiasem mówiąc, na Radożowie pojawił się kolejny ciekawy artykuł и inny.

odkrycia

W rzeczywistości kamery wykorzystujące matryce filtrów Bayer (CCD, CMOS - to nie ma znaczenia) nie mają zadeklarowanej rzeczywistej liczby „rzeczywistych” pikseli. Na matrycy istnieje tylko zestaw subpikseli (elementów fotograficznych) wzoru Bayera, z których za pomocą specjalnych złożonych algorytmów tworzone są „prawdziwe” piksele obrazu. Na ogół kamera w ogóle nie widzi kolorowego obrazu, procesor kamery zajmuje się tylko liczbami abstrakcyjnymi, które odpowiadają za konkretny odcień czerwieni, błękitu lub zieleni, a tworzenie kolorowego obrazu jest to tylko sztuczki matematyczne. Właściwie to właśnie dlatego tak trudno jest uzyskać „poprawne” odwzorowanie kolorów na wielu koronach koronowych.

Powiązane materiały

- Pełnoklatkowe systemy bezlusterkowe. Dyskusja, wybór, rekomendacje.

- Przycięte systemy bezlusterkowe. Dyskusja, wybór, rekomendacje.

- Przycięte systemy bezlusterkowe, które zatrzymały się lub kończą swój rozwój

- Cyfrowe systemy lustrzane, które zatrzymały się lub kończą swój rozwój

- JVI lub EVI (ważny artykuł, który odpowiada na pytanie 'lustro lub bez lustra')

- O bateriach bezlusterkowych

- Prosty i przejrzysty średni format

- Szczególnie szybkie rozwiązania chińskich marek

- Wszystkie najszybsze obiektywy zmiennoogniskowe z autofokusem

- Wszystkie najszybsze obiektywy stałoogniskowe z autofokusem

- Lustrzana pełna klatka na bezlusterkowym średnim formacie

- Wspomagacze prędkości autofokusa

- Jeden obiektyw, by rządzić światem

- Wpływ smartfonów na rynek fotograficzny

- Co dalej (przewaga smartfonów)?

- Wszystkie zapowiedzi i nowości obiektywów i aparatów

Komentarze do tego posta nie wymagają rejestracji. Każdy może zostawić komentarz. Wiele różnych urządzeń fotograficznych można znaleźć na AliExpress.

Przygotowany materiał Arkady Shapoval. Szkolenia/Konsultacje | youtube | Facebook | Instagram | Twitter | Telegram

I tak to naprawię :)

milion = 10^6

miliard = 10 ^ 9, miliard również = 10 ^ 9, tylko pierwsze imię jest tradycyjne i akceptowane w języku rosyjskim, a drugie jest naukowe i międzynarodowe.

bilion = 10^12

ale liczba 4 398 046 511 104 to cztery biliony trzysta dziewięćdziesiąt osiem miliardów (miliardów) czterdzieści sześć milionów pięćset jedenaście tysięcy sto cztery.

odpowiedź

Cóż, na pewno: matematyczny pokaz schizodownów! Od FMTI do entuzjastów fotografii! Matematycy wkrótce zbudują model kataru i obliczą prawdopodobną liczbę kichnięć w zależności od masy bezwładnej smarka... I na podstawie tego modelu wyprowadzą optymalną użyteczną liczbę pikseli w matrycy utworzonej przez chusteczkę... Żyjmy bogato i szczęśliwie!

odpowiedź

Podejrzewam, że bez matematyków i ich prac nadal musielibyśmy zajmować się malowaniem naskalnym. Cóż, lub pomaluj farbami olejnymi.

Filtry Bayera i interpolacja to jedne z niewielu sposobów na uzyskanie obrazów z matrycy. Jeśli policzymy cztery subpiksele jako jeden piksel, otrzymamy obraz o połowę mniejszy pod względem wysokości i szerokości. Ale jednocześnie stracimy tę nieistotną część informacji, która jest uzyskiwana przy mieszanym użyciu różnych kanałów, w tym informacji o podwojonej jasności z dwóch zielonych subpikseli.

odpowiedź

Cztery subpiksele nie mogą być uważane za jeden piksel, ponieważ każdy zawiera inne informacje, nawet pomimo obecności filtra.

odpowiedź

Dlaczego liczysz 3 subpiksele RGB jako jeden na monitorze? Tam też każdy ma inne informacje. W Bayerze różnica jest plus jeden zielony subpiksel, co teoretycznie powinno zwiększyć wyrazistość kosztem koloru.

odpowiedź

Oprócz Aleksandra

Zielony, dodatkowy piksel jest tworzony w celu zwiększenia czułości na zieleń.

Tak się złożyło, że człowiek jest prawie obojętny na niebieski i bardziej potrzebuje zieleni.

Jest coś takiego, czułość spektralna: EY = 0,30ER + 0,59 EG + 0,11EB

W rzeczywistości na komputerach 16 bitów koloru jest zakodowanych jako 565 (RGB) bitów na piksel, jeden bit daje dwukrotnie większy zakres pomiarowy. Co prawie wpisuje się w powyższą formułę.

Aby nie zawracać sobie głowy matematyką, zrobiliśmy jeszcze jeden dodatkowy piksel, co jest również prostsze technologicznie - aby wszystkie piksele były takie same.

Dlatego 4 piksele (RGBRG) łatwo zamieniają się w 0,30ER + 0,59 EG + 0,11EB, a następnie w RGB.

odpowiedź

Zgadza się, nie fotografowie, ale odbiorcy obrazu, rejestratory zdjęć, konsumenci informacji o kolorze, liczniki pikseli… Czy próbowałeś policzyć liczbę pociągnięć pędzla na obrazach Leonarda? Cześć!! Praca to morze, a mózg działa, nie wysycha ...

odpowiedź

Młody człowieku, lepiej zazdrościć mózgowi w ciszy, a jednocześnie lepiej uczyć się, aby zawęzić lukę, a zazdrość słabnie

odpowiedź

Więc chcę wstawić moje „5 centów” :)

-

1) Po pierwsze, mam nadzieję, że po tym, jak wszyscy dowiedzą się o mechanizmach debayeryzacji, w ich życiu nic się nie zmieni: nie zaczną masowo pozbywać się aparatów cyfrowych, kasować ulubione zdjęcia, wspominać samobójstwo („Och, jak mogłem znieść takie oszustwo przez cały czas?”) itp.

-

2) Po drugie, ktoś zapytał producentów aparatów, co rozumieją przez „PIXEL”? Dlaczego wszyscy zebrani tutaj są pewni, że zostali oszukani, oszukani, rzuceni? Czy Nikon lub Canon przekonali nas, że mówimy o RGB, RGB lub o innych wielokanałowych pikselach? Mówi się nam o liczbie komórek w matrycy jako całości (w sumie pikseli) oraz o tym, ile UNIKATOWYCH kombinacji (czyli tego, co stanie się potem pikselami na ekranie) kamery i oprogramowanie zbierają z tych komórek (efektywne piksele).

-

3) Po trzecie, nie mówimy o wypełnieniu niektórych pustych przestrzeni nieistniejącymi danymi uśrednionymi (interpolacja) lub przewidywanymi (ekstrapolacja). Mówimy o tym, że subpiksele podczas debayeryzacji można łączyć na różne sposoby. Każda kombinacja jest wyjątkowa, co oznacza, że może twierdzić, że staje się pikselem ekranu.

-

4) Po czwarte, nadal cholernie dobrze, że nie podjęli jeszcze tematu, jak te piksele, które pojawiają się w niezrozumiały sposób, są różnie wyświetlane na różnych ekranach, a tym bardziej - jak powstaje z nich wydrukowany raster! :)

-

Wszystko włożone „5 kopiejek”, pobiegnę zrobić zdjęcia, inaczej czuję, że marnuję cenny czas.

odpowiedź

Prenumeruję każdy grosz :)

odpowiedź

twoje 5 kopiejek to dokładnie 4.

Czy produkujecie również aparaty fotograficzne? ))

odpowiedź

Myślę nad tym :).

A do tego potrzebne są cudzysłowy, aby jedna rzecz mogła być nazwana przez drugą.

odpowiedź

Cóż, przynajmniej jedna wykształcona osoba.

To, co jest opisane w artykule, wcale nie jest nowością, ale dla zainteresowanych, a zwłaszcza fizyków, jest to od dawna znana prawda. Sposób, w jaki to się robi, to jedyna słuszna decyzja. Co byś chciał? Aby każdy piksel pochodził z triady RGB? A ta osoba po tym deklaruje, że 36 megapukelów na uprawie to dużo? Jaki byłby wówczas rozmiar mikrosoczewek, gdyby każdy piksel składał się z trzech wrażliwych elementów? Naucz się materiału, a wtedy nie będziesz zaskoczony prawdziwym stanem rzeczy. Producent po prostu dba o nas, czyniąc piksel „pogrubiony” i nie ma tu żadnego oszustwa.

odpowiedź

>> Sposób, w jaki to się robi, to jedyna słuszna decyzja

Dlaczego to jest poprawne? Fakt, że twoje zdjęcia zaczęły ważyć więcej, a ilość przerysowanych megapikseli jest fajniejsza.

>> Producent po prostu dba o nas, czyniąc piksel „pogrubionym” i nie ma tu żadnego oszustwa.

Święta niewinność. Producent to burżuj, któremu zależy tylko na własnym zysku i niczym więcej. Na przykład marketerzy sztucznie programowo ubijają niektóre żetony, zmuszając ich w ten sposób do kupowania droższych modeli. Zastępują terminy, aby liczby były większe, milczą, że ten termin został zastąpiony.

odpowiedź

Piksele wcale nie są przesadzone, ale prawdziwe!!! Aby zdobyć spuchnięte piksele, najpierw naucz się dopasowywać!!! Naprawdę chciałem powiedzieć nieprzyjemne słowa tymi słowami, ale się powstrzymam. Tak, byłbyś pierwszym, który wył na próg dyfrakcji, brak ostrości i ogromny szum, ze względu na minimalny obszar elementów światłoczułych, gdyby każdy piksel został utworzony z trzech sensorów. Pamiętaj: większy element światłoczuły zbiera więcej fotonów, stąd zmniejszony szum, niższy próg dyfrakcji, lepsza ostrość.

odpowiedź

Masz rację co do rozmiaru elementu, ale to nie odróżnia deb od rozmycia. Zadłużenie to w zasadzie banalna plama. Z czujnika 10*10 uzyskam 100 bajtów informacji o obiekcie. Jeśli zrobisz zdjęcie 10 * 10, to jest to 300 bajtów (3 bajty na piksel). Skąd masz 200 bajtów nowych informacji o obiekcie? Uśredniłeś to z sąsiednich pikseli, to jest banalne rozmycie.

Eksperyment myślowy. Robimy zdjęcie, powiedzmy 100x100 (najlepiej ostrzejsze). A na siatce Bayera w każdym pikselu zostawiamy tylko 1 subpiksel, a wygaszamy pozostałe 2 subpiksele. Czy możesz użyć debayeryzacji tego zdjęcia, aby uzyskać oryginalny obraz? Czy możesz mi powiedzieć, jaka była jasność wygaszonych subpikseli w każdym pikselu? Nie powiesz na pewno, posmarujesz maksimum sąsiednich.

Jeśli chodzi o materiał, zdmuchujesz policzki. Jeśli się nie zgadzasz, argumentuj, a potrząsanie pustym powietrzem jest bezużyteczne.

odpowiedź

Ta sama ilość informacji z pliku RAW może być analizowana i interpretowana na różne sposoby. Z różną jakością, szybkością, dokładnością w zależności od zadań. I wiele będzie od tego zależeć.

-

Zrób kilka trudnych zdjęć RAW za pomocą różnych konwerterów: nowoczesnego i dziesięcioletniego. Poczuj różnicę w hałasie, szczegółach, kolorze. Czy zwiększyliśmy ilość informacji wstępnych? Nie, właśnie nauczyliśmy się lepiej z nim pracować i w rezultacie otrzymaliśmy znacznie ciekawszą wersję.

odpowiedź

Producent to burżuj, który ma w swoim zespole dobrych korektorów, prawników, prawników, marketerów i innych mądrych ludzi. Dlatego producent DOKŁADNIE WIE, CO NAZYWA słowem „piksel”. A jeśli to nie pokrywa się z moimi, twoimi lub innymi opiniami, to już są nasze problemy.

-

Nie ma oszustwa, jest słowo, w którym różni ludzie nadają różne znaczenia.

Dla Ciebie na przykład piksel to punkt widoczny na ekranie, którego charakterystykę opisują składowe jasności kanałów RGB.

W przypadku, powiedzmy, drukarki jest to warunkowa kropka, która słabo próbuje wyświetlić się na ekranie po konwersji jako piksel RGB, ale w rzeczywistości ma 4 kanały (CMYK).

Producenci konkretnych kamer w odniesieniu do konkretnych matryc mają własne rozumienie piksela.

-

Nie ma jednego poprawnego rozwiązania dla tego, co powinno się nazywać „pikselem” lub „subpikselem”. Każdy ma w tej sprawie swoje zdanie. Ważne jest, abyśmy wszyscy, gorąco dyskutujący na ten temat, zrozumieli teraz porządek rzeczy i mogli nazywać rzeczy po imieniu.

odpowiedź

Zarówno na ekranie, jak i na wydruku piksel jest elementarną częścią obrazu, który może mieć dowolny kolor, nie tylko czerwony, niebieski czy zielony. Producenci aparatów interpretują termin piksel nie tak jak wszyscy, ale dlatego, że jest to dla nich bardziej opłacalne. A producenci gigabajtów dysków twardych to 10E9 bajtów, a nie 1024 * 1024 * 1024. Ponieważ jest to dla nich bardziej korzystne.

odpowiedź

Zgadza się - w dziesiątkę

odpowiedź

Przedrostek „giga-” w ISO oznacza 10 do dziewiątej potęgi i nic więcej.

Mylisz „gibi-” z „giga-”.

Dowiedz się o prefiksach binarnych:

http://ru.wikipedia.org/wiki/%D0%94%D0%B2%D0%BE%D0%B8%D1%87%D0%BD%D1%8B%D0%B5_%D0%BF%D1%80%D0%B8%D1%81%D1%82%D0%B0%D0%B2%D0%BA%D0%B8

odpowiedź

To znaczy według SI i JEDEC :)

odpowiedź

Vadim, prawda jest całkowicie po twojej stronie. Ja z kolei nawet nie domyśliłem się, że tak wielu ludzi nawet nie reprezentowało procesu zbierania informacji z matrycy. Myślałem, że wszyscy fotografowie cyfrowi już rozumieją ten proces. I okazuje się...

odpowiedź

Oczywiście piksel może mieć dowolny kolor. Tylko ten kolor trzeba jakoś wyznaczyć. Piksele monochromatyczne (niekoniecznie biało-szaro-czarne) mogą być opisane przez jeden kanał, kolorowe piksele przez trzy lub więcej i mogą być reprezentowane na różne sposoby (HSL, LAB, RGB, CMYK itp.).

Producenci aparatów podają całkowitą liczbę pikseli monochromatycznych (które przenoszą informacje w jednym kanale, niezależnie od tego, jaki to kanał).

Piksele na ekranie są wielokanałowe (czyli tak je odbieramy). Ile jest kanałów, czy są subpiksele, zależy od technologii obrazowania.

A w druku kolorowym piksele są również wielokanałowe. A kanały, zwykle, co najmniej o jeden więcej niż wyświetlane na ekranie. Zależy to również od technologii druku.

-

Tych. piksele są różne. Zrozumienie tej prostej tezy ułatwi życie.

odpowiedź

Przeczytaj tutaj http://www.cambridgeincolour.com/ru/tutorials/camera-sensors.htm , tylko w zamyśleniu, bardzo czytelnie namalowany.

odpowiedź

http://arttower.ru/wiki/index.php?title=%D0%A4%D0%B8%D0%BB%D1%8C%D1%82%D1%80_%D0%91%D0%B0%D0%B9%D0%B5%D1%80%D0%B0

Oto na końcu przykład z gęsią. A na koniec piszą:

Jak widać na zdjęciu, ten obraz okazał się bardziej rozmazany niż oryginalny. Efekt ten wiąże się z utratą niektórych informacji w wyniku działania filtra Bayera.

Tych. Filtr Bayer nie przywraca oryginalnych informacji w 100%! interpoluje (rozmazuje) go z sąsiednich pikseli.

odpowiedź

Zwariowany przykład :)))

A co z oryginalnym obrazem bez debayeryzacji? Lub sfilmowany, a następnie zeskanowany?

Nikt nie mówi: strzelajmy na trzech-czterech... matrycach jednocześnie, zdobądźmy prawdziwie wielokanałowe piksele, porównajmy to z żałosnymi "kratami Bayera" - i jakby poczuj różnicę.

W tej epickiej dyskusji ludzie próbują przekazać tylko kilka tez:

1) DOWOLNE informacje o DOWOLNYM obiekcie odtworzonym z DOWOLNEGO źródła nie są oryginalne i mają dyskretną jakość. Wniosek: chodź na koncerty na żywo, podróżuj, oglądaj na żywo zachody słońca, powąchaj kwiaty, delektuj się każdą łyżką barszczu, kochaj swoich bliskich itp.

2) jeśli nie jesteś inżynierem (z natury), ale fotografem (z zawodu lub masz takie hobby), mniej przejmuj się dogłębnymi technicznymi szczegółami procesu robienia zdjęcia (jak ładowane są ogniwa czujników itp. .). Niech inżynierowie o tym pomyślą. Wniosek: ćwicz, doskonal swoje umiejętności. Z czasem żelazo będzie się poprawiać. A to, czy staniesz się lepszy, zależy od Ciebie.

3) aby nie czuć się oszukanym, określ rzeczy, które Cię interesują. Ludzie często nazywają tę samą rzecz inaczej lub odwrotnie, nadają tym samym słowom różne znaczenia. Wniosek: umiejętność znalezienia wspólnego języka pomaga w sklepie, w pracy iw życiu rodzinnym.

4) prawda rodzi się w sporach. Nie jesteśmy tutaj, aby zalewać stronę Arkadego ani dowiedzieć się, kto jest mądrzejszy. Na nowo przyjrzałem się niektórym aspektom uzyskiwania i analizowania obrazu. To jest dla mnie interesujące, ponieważ. Jestem okulistą. Od tego dnia ktoś zacznie poprawnie używać przedrostków „kilo-”, „giga-”, „kibi-”, „gibi-”. Wniosek: konstruktywne dyskusje czynią świat lepszym :)

odpowiedź

Nie wiedziałem o Gibi. Okazuje się, że Windows nie wyświetla się zgodnie ze standardem, kto by pomyślał.

odpowiedź

Nawiasem mówiąc, tak, z powodu Microsoftu wielu napluło na zgodność ze standardami. Niedawno się o tym dowiedziałem.

odpowiedź

Szczerze mówiąc, absolutnie nie obchodzi mnie, jak są nazywani i pracują. Nie mam na to wpływu. A mówimy o widmie widzialnym… naszymi elastycznymi i jednocześnie bardzo niedoskonałymi oczami. Wszyscy inaczej widzimy i oceniamy. Figley wtedy napełnił głowę bzdurami. I zacznie się teraz: masz złą matrycę, masz „granaty złego systemu”…

Nie sądzę, żeby ktoś mnie oszukał lub zmylił... Bardziej martwi mnie kupno kolejnego tuszy lub szkła :), podróżowanie w różne ciekawe miejsca... i żeby moje nieszczęsne oczy zdążyły zobaczyć wystarczająco dużo piękna .

odpowiedź

Myślę, że rozumiem powód zadłużenia:

1. Dla producenta atrakcyjniejsza ilość megapikseli, no cóż, to zrozumiałe.

2. Teraz wymóg, aby kamera dawała na wyjściu najwyższej jakości gotowy obraz jpg. I żeby użytkownik nie musiał zawracać sobie głowy filtrami. Tych. jeśli potrzebujesz zastosować jakiś filtr, aby poprawić widoczną jakość zdjęcia, aparat powinien zrobić to sam, a nie pozostawiać tego użytkownikowi. Tutaj otrzymał macierz wartości10*10. Oczywiście jest tylko 100 bajtów informacji początkowych, a kto ich potrzebuje, jest surowy. A kto potrzebuje gotowego zdjęcia, aparat zwiększy rzeczywistą rozdzielczość o 2 * 2 \u4d 10 razy, interpolując brakujące piksele (zadłużenie), a następnie doda ostrość, poprawne kolory i coś jeszcze. Efektem końcowym jest zdjęcie o najlepszej widocznej jakości. Owszem, jak zrobisz zdjęcie 10x5 z matrycy 5*1 poprawnie, to nie będzie w nim żadnych przesadnych informacji, ale będzie wyglądało naprawdę gorzej. Tych. dla siebie doszedłem do tego, że piksele zapisane na aparacie 4/XNUMX są prawdziwe, a reszta jest interpolowana. Może nie jest to złe, ale dla ludzi ważna jest widoczna jakość, a to, jak faktycznie jest ona uzyskiwana, pobierana lub interpolowana, nie jest dla nich ważna.

odpowiedź

Nie rozumiem. Zrób obraz RAW, zmniejsz go o połowę, a następnie przeskaluj do oryginalnego rozmiaru. A następnie porównaj zdebayeryzowane, podpuchnięte piksele z twoimi uczciwymi pikselami. Przykład nie jest do końca poprawny, ale nadal można wyciągnąć pewne wnioski.

Filtr Bayer to inteligentne rozwiązanie inżynierskie, które pozwala optymalnie wykorzystać obszar matrycy. „Słuszną decyzją” jest wzięcie kwadratu, umieszczenie w nim trzech czujników R, G, B (jeden róg pusty), uśrednienie wszystkiego do jednego piksela i uzyskanie obrazu o bokach 4000x3000 z matrycy 2000x1500 pikseli. Wystarczy dołożyć kolejny zielony czujnik w „pusty” róg i otrzymamy „dodatkowe” 60% informacji o jasności (udział kanału zielonego to 60%, 30% - czerwony, 10% - niebieski). Możesz go po prostu wyrzucić lub „wymieszać” za pomocą maty. przekształcenia (bardziej złożone niż zwykła interpolacja liniowa lub nawet sześcienna) do obrazu, uzyskując znacznie wyższą rozdzielczość jasności.

odpowiedź

>>Zrób zdjęcie uzyskane z RAW

Gdzie to zdobyć? Każdy konwerter daje już przetworzone.

http://arttower.ru/wiki/index.php?title=%D0%A4%D0%B8%D0%BB%D1%8C%D1%82%D1%80_%D0%91%D0%B0%D0%B9%D0%B5%D1%80%D0%B0

Oto zdjęcie gęsi. To jak oryginalny przedmiot. Zrobili z tego macierz Bayera, tj. jaka byłaby matryca idealnego aparatu z idealnym obiektywem. Następnie na tę macierz zastosowano zadłużenie, tj. jak zrobiłby aparat. Powstałe zdjęcie nie jest równe oryginałowi! Nie równe! Teraz, gdyby fotik miał uczciwe piksele rgb, oryginalny obraz byłby bez żadnych d-cji. A więc jest to proste rozmycie, które widać przy porównaniu oryginalnego i końcowego zdjęcia gęsi.

Tak, d-tion jest prawdopodobnie nieco bardziej złożoną transformacją niż prosta interpolacja liniowa lub sześcienna, ale to nie znaczy, że nie jest interpolacją. D-tion to prawdziwa interpolacja. Z wiki:

Interpolacja, interpolacja - w matematyce obliczeniowej sposób na znalezienie wartości pośrednich wielkości z istniejącego dyskretnego zbioru znanych wartości.

To jest.

odpowiedź

> Otrzymane zdjęcie nie jest równe oryginałowi!

Czy ktoś twierdzi inaczej?

Jeśli postępujesz „uczciwie”, jak prosisz, będziesz musiał oślepić jednego z każdego zestawu czterech pikseli, a nie cztery, jak robi to algorytm debayeryzacji. W rezultacie Twój obraz będzie dwukrotnie mniejszy pod względem szerokości i wysokości. A jeśli powiększysz go do rozmiaru oryginalnego obrazu, to wynik po debayeryzacji będzie wyglądał DUŻO lepiej, bo został uzyskany dzięki informacjom, które proponujesz wyrzucić.

Filtr Bayera umożliwia rozmieszczenie elementów światłoczułych w formie siatki, zastosowanie dwóch zielonych pikseli zamiast jednego zwiększa rozdzielczość i dostarcza dodatkowych informacji dla lepszej transmisji odcieni zieleni (i pośrednio jasności).

Możesz układać elementy jeden na drugim, są takie macierze. Fale o różnej długości przenikają na różne głębokości, dzięki czemu z jednego „piksela geometrycznego” można uzyskać trzykrotnie więcej informacji, ale tam też nie wszystko jest gładkie. Możliwe jest rozbicie strumienia świetlnego na trzy i skierowanie światła na trzy różne matryce, ale jest to kosztowne i kłopotliwe.

odpowiedź

Jeśli zrobisz prawie każde zdjęcie (szczególnie o niskiej rozdzielczości) i zwiększysz jego rozdzielczość 2*2 razy przez interpolację dwuliniową, będzie ono również wyglądało DUŻO lepiej bez czwartego kanału. Ale to nie jest powód, aby robić to ze wszystkimi plikami, zwiększając ich rozmiar o 4! czasy.

Tak, jak pisałem powyżej, wymagania dla aparatów wydają się być takie: aparat musi wyprodukować gotowe zdjęcie jpg o najwyższej możliwej jakości, po wykonaniu wszystkich możliwych filtrów samodzielnie. Rozmiar zdjęcia nie ma znaczenia. Nie jest tak ważne, w jaki sposób jest ona uzyskiwana z prawdziwych pikseli lub przerysowanych.

odpowiedź

Oto coś, czego Oleg w żaden sposób nie może zrozumieć, czym różnią się piksele jednokanałowe (monochromatyczne) od wielokanałowych (kolorowych). I nic nie możesz na to poradzić...

-

W związku z tym interpolacja jako uśrednianie nie ma z tym nic wspólnego. Debairyzacja to nie uśrednianie, ale uzyskiwanie wielokanałowego piksela z grupy monochromatycznych.

-

W tym przypadku oczywiście konieczne jest użycie wszystkich możliwych kombinacji grup, ponieważ da to więcej RZECZYWISTYCH informacji niż użycie każdego monochromatycznego piksela tylko raz, a następnie skalowanie w górę.

-

A ta gęś jest głupia... Ludzie zrobili zdjęcie z zestawu pikseli RGB, przycięli je do monochromatycznego, czyli. wyrzucili 2 kanały (2/3 informacji), a potem mówią: „Widzisz, obraz się degraduje”. OCZYWIŚCIE to poniżające, pozostała tylko jedna trzecia informacji! I tylko dzięki debairyzacji ten obraz można jeszcze w ogóle oglądać.

odpowiedź

Tak, ludzie wyrzucili 2/3 informacji. Cóż, aparat też nie pobiera 2/3 informacji, powiedzmy, że zielona składowa światła, która trafia na czerwoną lub niebieską komórkę, po prostu znika. Z gęsią wszystko jest w porządku.

A jak myślisz, jaki jest właściwy sposób na zrobienie przykładu z gęsi? Pomyślcie sami, jest zdjęcie gęsi, powiedzmy 100*100*3 = 300 bajtów, matryca Bayera zajmie tylko 100 bajtów. Jak nie przekręcić ze 100 bajtów to nie odzyskasz tych samych 300. Nie zgadzam się? nie ma problemu, zróbmy gęś tak, jak chcesz. Wyjaśnij jak.

odpowiedź

Wyrzucanie i niewyjmowanie to dwie różne rzeczy. Te jednokanałowe piksele przenoszą informacje tylko o jednym kanale. Ale nie przestają być pikselami. I nie obiecano nam żadnych konkretnych pikseli. Obiecywali piksele - dali piksele. Ale czym są te piksele i czym różnią się od ekranowych, dzięki Wam dowiedzieliśmy się i „przeżuliśmy” bardzo szczegółowo.

odpowiedź

Ogólnie tak. Nigdzie nie jest napisane, że są to piksele trzykanałowe. Jeśli niechęć do przesadzonych informacji w pliku można umieścić na fotiku niższą rozdzielczość i tym samym uzyskać uczciwe tłumaczenie pikseli Bayera na rgb, to producenci pozostawiają wybór użytkownikowi. Pewnie na próżno je oczerniam.

Cóż, wtedy rozdzielczość monitorów można również zapisać w pionie 3 razy więcej, tam też nikt nie obiecywał piksela rgb :).

odpowiedź

Piksele kamery i piksele ekranu są jak kafelki. Jest taniej, jest drożej, jest więcej, jest mniej. Ale i to i tamto są kafelkami, i to i tamto są pikselami.

Ponieważ piksele matrycy aparatu są jednokanałowe (monochromatyczne), zawierają trzy razy mniej informacji niż piksele ekranu. Nie są równe. Ale to są piksele. Uczciwy. Prawdziwy.

-

Jak najłatwiej wyjaśnić?

odpowiedź

Nie wiem. Ktoś uparcie wierzy, że producenci go oszukują. Jak w żydowskim spisku masońskim, każdy głupio podwaja obraz, wyostrza i sprzedaje go jak prawdziwy. Więc go zdenerwuję, w JPEG, RGB jest konwertowane na YUV - kanał luminancji i 2 różnice kolorów. Jasność koduje całość, a dla różnicy kolorów pozostają dwa na cztery piksele. A to po debayeryzacji! Głupcy, głupcy...

odpowiedź

Wiem na pewno, że z matrycy Bayer 10*10 nie da się w żaden sposób dokładnie odtworzyć oryginalnego obrazu 10*10*3, w tym d-tion. Ostateczny obraz będzie bardziej rozmyty niż oryginał, a masoni nie mają z tym nic wspólnego, czysta matematyka. Nie wiem, jak koduje JPEG, nie będę się spierać (ale zawsze myślałem, że w serii Fouriera jest coś ułożonego). Ale twoja logika jest taka, dodajmy do obrazu 200% zawyżonych pikseli, w każdym razie część z nich zostanie utracona po kompresji JPEG. Zaznaczam, że JPEG to zawsze pogorszenie jakości obrazu (widoczne na kontrastowych zdjęciach), a po JPEG nie tylko przerysowane, ale i prawdziwe zostaną utracone!

Powyższy przykład z gęsią jest bardzo odkrywczy. A może ty Roman też się z nim nie zgadzasz? Zróbmy przykład z gęsi tak, jak chcesz i upewnij się, że nie uzyskamy oryginalnej jakości obrazu.

odpowiedź

:)))

Nie ma „oryginalnego obrazu” gęsi. Jest gęś :). To jest PIERWOTNY PRZEDMIOT. Nigdy nie będziemy w stanie uzyskać idealnego obrazu. Widzieliśmy kontur - chcemy zobaczyć części ciała; widzieliśmy części ciała, chcemy zobaczyć pióra; widzieliśmy pióra, chcemy zbadać każdy „kosmek”; widzieliśmy każde „strzępienie”, chcemy zobaczyć każdy kleszcz na nim siedzący itp. Doskonałość nie ma granic.

-

Tak więc GUS (a nie jego zdjęcie) jest fotografowany aparatem na matrycy z baerską kratą. To jest ORYGINALNY WIZERUNEK.

-

Informacje podczas fotografowania nie stają się mniejsze. Jest go dokładnie tyle, ile ten typ matrycy może fizycznie początkowo uzyskać w tym aparacie przy takich ustawieniach i warunkach fotografowania. Tych. niektóre monochromatyczne piksele.

Znowu monochromatyczny nie oznacza skali szarości. Tyle, że każdy piksel niesie informacje o jednym kanale (w tym przypadku czerwony, niebieski, zielony, zielony nr 2).

-

Gdybyśmy początkowo mieli matrycę wielokanałową (np. wielowarstwową) i z jakiegoś powodu zawiesiliśmy na wierzchu kratkę Baera, to oczywiście stracilibyśmy około 2/3 informacji. Ale nic nie straciliśmy, początkowo mamy czujnik mniej doskonały. Cokolwiek z nim zrobisz, nie „wykopie” dla nas więcej informacji.

-

Wtedy oryginalna informacja również nigdzie nie trafia: jest analizowana, interpretowana i konwertowana na wielokanałowe piksele, które są zrozumiałe dla ekranu monitora. Możesz to zrobić w jednym przejściu (każdy monochromatyczny piksel jest używany raz), możesz to zrobić w kilku przejściach (rozważane są wszystkie możliwe kombinacje grup po 4 sąsiednie piksele + możliwie większe grupy i nieregularny kształt). Im więcej podań – im więcej szans na wyciśnięcie maksimum z dostępnych informacji, tym większe prawdopodobieństwo, że uzyskany obraz spełni oczekiwania. Ale ilość początkowych informacji znowu się nie zmienia.

odpowiedź

>>Nie ma „oryginalnego zdjęcia” gęsi. Jest gęś...

Nie poprawnie. Nie możemy opisać żywej gęsi w nieskończoność, to prawda. Ale wyobraziliśmy sobie abstrakcyjną gęś składającą się z kwadratów. Cóż, to tak, jakbyśmy nie robili zdjęcia samej gęsi, ale robili zdjęcie gęsi. Powiedzmy, że mamy zdjęcie gęsi 100*100*3. Idealny aparat z idealnym obiektywem z uczciwą matrycą 100*100*3 zrobienie takiego zdjęcia gęsi oczywiście da na wyjściu oryginalny obraz gęsi. Idealny aparat z matrycą Bayera 100 * 100 * 1 da matrycę Bayera, z której za pomocą przekształceń detionowych nie uzyskuje się oryginalnego zdjęcia gęsi, ale uzyskuje się bardziej rozmyte zdjęcie. Jak pokazano w tym linku.

>>Informacje nie zmniejszają się podczas fotografowania. Jest go dokładnie tyle, ile ogólnie fizycznie może uzyskać ten typ macierzy

TAk. Ta macierz jest w stanie odbierać od obiektu powiedzmy 10*10=100 bajtów informacji, nie zmniejsza się, ponieważ niczego nie wyrzucamy. Robi się coraz większy, dodajemy zawyżone 200 bajtów. Jakbyśmy naprawdę otrzymali z obiektu 300 bajtów, a w rzeczywistości tylko 100.

Spójrz, musimy przekonwertować 1 piksel jednokanałowej matrycy Bayera na 3-kanałową. Niech to będzie zielony piksel. Ale fizycznie nie znamy wartości ani czerwonego, ani niebieskiego koloru obiektu w miejscu tego zielonego piksela. Matryca nie usunęła, odcięła tę informację. Skąd go wziąć, bierzemy go z sąsiedniego piksela, naiwnie wierząc, że wartości kolorów sąsiednich pikseli są w przybliżeniu podobne. Ale wcale tak nie jest. Na przykład obiekt źródłowy to jasnożółta (czerwona+zielona) kropka o 1 pikselu na zielonym tle. I ten punkt całkowicie wpadł w ten 1 jednokanałowy zielony piksel. W sąsiednich pikselach nie będzie informacji o jego czerwonej składowej, jest tylko informacja o zielonym tle. De-tion da nam tę zieloną kropkę. O ile uczciwa trzykanałowa matryca zobaczy, że kropka ma kanał czerwony, a w efekcie dostaniemy żółty kolor kropki.

odpowiedź

„Na przykład oryginalny obiekt to jasnożółta (czerwona + zielona) kropka o rozmiarze 1 piksela na zielonym tle. I ten punkt całkowicie wpadł w ten 1 jednokanałowy zielony piksel. Nie będzie informacji o jego czerwonym składniku w sąsiednich pikselach” - twoje myśli tylko raz jeszcze potwierdzają nieznajomość materiału :)

Taka sytuacja jest niemożliwa, ponieważ przed matrycą znajduje się również specjalny filtr.

odpowiedź

Mówią, że w niektórych modelach filtr antyaliasingowy nie znajduje się przed matrycą. A skąd wpadłeś na pomysł, że promień rozmycia tego filtra jest większy niż rozmiar piksela? Może rozmywa się o 0.1 piksela, a wtedy równie dobrze może być jasna kropka wielkości piksela.

odpowiedź

Aparaty bez filtra - półtora modeli. Co więcej, brak tego filtra przedstawiany jest jako narzędzie dla profesjonalistów, ludzi, którzy wiedzą, dlaczego go potrzebują.

A jeśli chodzi o stopień rozmycia, to wydaje się, że warto go rozmyć tak, aby trafiał w sąsiednie piksele. Nawet jeśli o 0.1 piksela będzie to oznaczać, że część informacji spadnie już na sąsiadów. W praktyce jest ich więcej. Powtarzam raz jeszcze, przestudiuj materiał, zanim wyciągnę wnioski dotyczące opuchlizny i interpolacji.

PS Arkady proszę o usunięcie mojego podobnego komentarza powyżej, został zacytowany w złym miejscu, wszystko się przeniosło.

odpowiedź

Kolejną „uczciwą opcją” jest zwiększenie liczby pikseli na matrycy, zmniejszając ich wymiary liniowe. Ale tutaj napotykamy szereg problemów. Narastają szumy (ze względu na gęste ułożenie elementów na matrycy ich nagrzewanie jest większe, do pomiarów wprowadza się więcej zniekształceń). Zaczynają się problemy z dyfrakcją (pisaliśmy o tym nieco wyżej). Czułość spada, tk. liczba fotonów ze źródła światła jest nadal skończona, a wraz ze zmniejszaniem się rozmiaru elementu światłoczułego liczba fotonów padających na niego z tej samej sceny będzie się zmniejszać. To jest droga donikąd.

odpowiedź

>>Kolejna "uczciwa opcja"

Nie kolejną, ale jedyną uczciwą opcją zwiększenia rozdzielczości jest zwiększenie liczby pikseli.

>> To droga donikąd.

A producenci matryc nawet nie wiedzą. Ilość pikseli na matrycy jest coraz większa.

odpowiedź

> A producenci matryc nawet nie wiedzą. Ilość pikseli na matrycy jest coraz większa.

Jeśli w tym samym czasie zwiększa się powierzchnia matrycy, jest to całkiem uzasadnione. A w pozostałych po prostu działa głównie marketing. W porządku, wraz z poprawą technologii, problem hałasu zostaje jakoś rozwiązany. Ale nikt jeszcze nie anulował dyfrakcji, a rozdzielczość optyki musi odpowiadać rozdzielczości matrycy, w przeciwnym razie nie będzie sensu zwiększać.

odpowiedź

>> Wiem na pewno, że z matrycy Bayer 10*10 nie da się w żaden sposób dokładnie odtworzyć oryginalnego obrazu 10*10*3, w tym d-tion.

To jest absolutnie bezdyskusyjne. Gdyby istniała idealna matryca, z której każdy fizyczny piksel dawałby obraz trójskładnikowy (a takie istnieją, pisałem już, ale daleko im do ideału), to w wyniku usunięcia informacji z tej matrycy otrzymalibyśmy obraz lepszej jakości. Ale na tym etapie możemy jedynie określić poziom oświetlenia czujnika i w odpowiedzi na to wytworzyć jakieś napięcie, które następnie digitalizujemy. Jeśli weźmiesz matrycę 4000x3000 i nie pokryjesz jej kolorowymi filtrami, otrzymasz uczciwy monochromatyczny obraz 12MP. Jeśli na górze matrycy umieścimy również siatkę filtrów barwnych Bayera, to otrzymasz również informację o kolorze. Stracimy część informacji o jasności z powodu filtrów. Ale po raz kolejny ta tablica przeniesie więcej informacji niż tablica 2000x1500 uśrednionych pikseli.

odpowiedź

>> ta tablica przeniesie więcej informacji niż tablica 2000x1500 uśrednionych pikseli

Macierz Bayer 4000x3000 przechowuje 12MB informacji. Szczerze mówiąc, żeby skompresować go do zdjęć 2000x1500 RGB, będzie to 9MB informacji, czyli strata 25% (tj. zamiast 2 zielonych kanałów tylko 1). A jeśli zrobisz de-tion i rozciągniesz go do zdjęć 4000x3000 RGB, otrzymamy 36MB informacji. Tych. lub stracić 25% lub zawyżać o 200%. W zasadzie te 200% możemy w każdej chwili napompować, nawet w czasie rzeczywistym, bezpośrednio podczas oglądania zdjęcia.

Ale 12 megapikseli jest znacznie bardziej atrakcyjny dla marketera niż 3 megapiksele. Chcą napisać 12. Ale marketerzy też nie mogą uczciwie przetłumaczyć zdjęcia, ponieważ jeśli aparat mówi o rozdzielczości 12 megapikseli, to na wyjściu nie może wyprodukować zdjęcia o rozdzielczości 3 megapikseli. Dlatego na fotiku napisane są prawdziwe jednokanałowe 12Mpix, a wyjście to te same 12, ale częściowo zawyżone trzykanałowe. 12=12 i wszystko dopasowane, a klienci nie mają pytań.

odpowiedź

> Macierz Bayer 4000x3000 mieści 12MB informacji

4000x3000x14 bitów = 21 MB (już nie 12)

> Zasadniczo możemy nadmuchać te 200% w dowolnym momencie, nawet w czasie rzeczywistym, podczas oglądania zdjęcia

Czy kiedykolwiek przetwarzałeś RAW? Na ile porządny konwerter go otwiera i „wieje” zwracał na to uwagę?

Pod każdym innym względem nie chcesz niczego zrozumieć, więc nie widzę sensu w przekonywaniu mnie, że jest inaczej.

odpowiedź

Konwerter działa dokładnie tak długo, jak pozwala na to sprzęt. Fotik sprawia, że jest to o wiele łatwiejsze i szybsze. W komputerach procenty są mocniejsze, oto fajniejszy algorytm. Jutro przyspieszą komputer 100 razy, programiści jeszcze mocniej napiszą filtr, a komputer będzie myślał tak samo przez kilka sekund i uatrakcyjni zdjęcie o 1%. To nie jest wskaźnik.

>> Pod każdym innym względem nie chcesz niczego rozumieć, więc nie widzę sensu przekonywania Cię, że jest inaczej

Do czego chcesz mnie przekonać? Fakt, że de-tion nie jest interpolacją? Czy to tak, że Macierz Bayer 10*10 jest w stanie odbierać informacje z obiektu o wielkości ponad 100 bajtów? A może jest możliwe zrobienie 100 bajtów prawdziwych informacji ze 300 bajtów prawdziwych informacji? W czym?

odpowiedź

Roman, tak nie ma sensu udowadniać :)

Niech człowiek dalej 4 razy zmienia rozmiar zdjęć i śpi spokojnie, myśląc, że nic nie traci a to tylko oszczędza miejsce na dysku :) A my jesteśmy głupi, będziemy dalej kręcić zdjęcia pełnowymiarowe, w których jedna trzecia informacji jest wymyślonych :)

odpowiedź

> Nie wiem jak koduje JPEG

Ale zainteresuj się. Zacznijmy od konwersji RGB na YUV. Całkowicie oszczędzamy kanał jasności, przerzedzamy dwa kanały różnicy kolorów. Możesz usunąć połowę pikseli z każdego kanału U i V, a różnica nie będzie widoczna dla oka. W rezultacie 33% informacji zostało odrzuconych stosunkowo bezboleśnie. Nawiasem mówiąc, w filmie odrzucają jeszcze więcej - około 50%.

Cóż, jest jeszcze fajniej.

Odebrane informacje są dzielone na bloki, z których każdy jest osobno kodowany. Każdy blok jest poddawany FFT. Zamiast zestawu wartości dla każdego piksela otrzymujemy zestaw częstotliwości. Tam obcinamy górne częstotliwości w zależności od stopnia kompresji, coraz bardziej pogrubiając obraz. I dopiero wtedy stosujemy rzeczywistą kompresję według metody Huffmana.

odpowiedź

Więc ja, Roman, przeczytałem ponownie Twój post i pomyślałem, że kwestie interpretacji i transformacji informacji graniczą z filozofią :).

Na przykład:

- biorę plik .nef o objętości 14 623 438 bajtów;

- staram się skompresować w WinRAR, najlepsza kompresja - otrzymuję 14 582 483;

- ok, wynik nie super, otwieram .nef w Photoshopie w sRGB, 8 bitów/kanał (ile tam mieliśmy?) I zapisuję w .tif bez kompresji, przeplatany, bez profilu kolorów, dostaję 36 671 508 bajty;

- podobna, ale używam kompresji LZW (bezstratnej) - 18 310 864 bajtów;

- podobnie, ale zamiast LZW wciskam .tif z WinRAR - 13 580 860 bajtów (tu zaczyna się magia ulicy!).

Teraz próbuję przygotować obraz do druku. Aby wszystko było przezroczyste, ręcznie konwertuję plik RAW otwarty w Photoshopie do sRGB, 8 bitów/kanał do CMYK, zapisuję w .tif bez kompresji - 48 879 468 bajtów.

Podobnie, ale z LZW - 30 024 372 bajtów.

Podobnie, ale nieskompresowany .tif wciskam WinRar - 24 462 690 bajtów.

Co ciekawe: w rzeczywistości nie zrobiliśmy nic specjalnego z oryginalnymi informacjami. W pierwszym przypadku został on przekonwertowany pod kątem odpowiedniego wyświetlania na ekranie. Drugi to drukowanie. Nie śmiem nawet oceniać, gdzie jest prawdziwy, gdzie jest napompowany. Powiedziałbym, że są to różne awatary o tych samych informacjach (z wyjątkiem utraty przy konwersji na inne profile kolorów).

Pozostaje pytanie: w jaki sposób spakowany, rozdęty 3-kanałowy plik .tif może zajmować MNIEJ miejsca niż podobnie spakowany plik .nef? Jest mniej PRAWDZIWYCH informacji?

odpowiedź

W RAW masz nieskompresowane dane z matrycy, bez debayeryzacji, po konwersji do TIFF dostajesz już zdebayeryzowany obraz, jest już trzy razy więcej subpikseli, przez co waży trzy razy więcej.

odpowiedź

To jasne, żadnych pytań

odpowiedź

Ale już pakowanie i kompresja to już inna kwestia, wszystko zależy od algorytmów i akceptowalnych strat. RAR prawie nie kompresuje prostych obrazów, jak widzieliście. Najprawdopodobniej czegoś brakuje.

odpowiedź

Bitowość została utracona, dodano kanały. I nagle okazało się, że pod warunkiem kompetentnego pakowania informacji, pełnoprawny raster trójpasmowy może zająć mniej objętości niż słabe, niepodważalne źródło.

A filozofią jest to, co uważa się za PRAWDZIWĄ ilość przechowywanych informacji wizualnych? Źródła rozmiaru RAW? Raster w pełnym rozmiarze? Która z opisanych przeze mnie rzeczy jest PRAWDZIWĄ ilością informacji, która jest SKOMPRESOWANA, a która PRZESYŁANA?

W końcu okazuje się, że te same informacje mogą zajmować różną objętość w zależności od sposobu prezentacji i środowiska użytkowania.

odpowiedź

Cóż, weź pod uwagę, że w rzeczywistości masz obraz na wyjściu z matrycy, zakodowany w przybliżeniu w ten sam sposób, który jest używany w formatach kompresji obrazu. W końcu, kiedy część informacji o kolorze jest odcinana w JPEG, nikt nie krzyczy, że go oszukuje? A tam przecież najłatwiej jest skompresować dwa razy z każdej strony, a następnie rozciągnąć. Majstrują jednak przy bardziej złożonych transformacjach.

odpowiedź

Krótko mówiąc, bardzo się starałem wyrazić pogląd, że ilość użytecznych informacji i objętość, którą one zajmują, to dwie różne rzeczy.

-

A ostatnio coraz trudniej jest zrozumieć, czy jest w stanie natywnym, skompresowanym czy zawyżonym.

odpowiedź

Skompresowane pliki RAW i JPEG z mojego Nikona D1X zajmują prawie tyle samo, dlatego fotografuję tylko w RAW-ie :) Oba są skompresowane, choć widać, że w JPEG są większe straty.

odpowiedź

Ogólnie dziękuję za przyjemną i pouczającą dyskusję.

A co najważniejsze, zostawiając tutaj myśli o megapikselach, zrobiłem ostatnio dużo fajnych ujęć, myśląc o zupełnie innych rzeczach :)

odpowiedź

Otóż w oparciu o definicję ilości informacji pobieranych z czujników - jest jakaś wartość. Ale sposób, w jaki jest prezentowany, może być inny. Entropia jest mniejsza - rozmiar wiadomości jest mniejszy, jest to cała informacja. Więcej entropii, więcej wiadomości.

Możemy stracić część informacji, dostosowując się do właściwości systemu wyjściowego (monitor) i systemu percepcji (oko). Na przykład monitor nie może (przeważnie) wyprowadzać więcej niż 8 bitów na piksel. A oko nie rozróżnia odcieni kolorów w cieniach. Itp. Tutaj ilość informacji maleje, a tym samym rozmiar wiadomości. Ale dzięki kompresji zmniejszamy entropię, pozostawiając wiadomość o takiej samej objętości. Konwersja do formatu 16 lub 32 bitów - zwiększona entropia (znane „nadmuchane piksele”).

odpowiedź

Na D7100 RAW przy 15,6 MP zajmuje od 20 do 26 MB. Nagrany RAW bez kompresji. Ale sądząc po tym, jak różni się ostateczna głośność, kompresja jest nadal wyraźnie stosowana, ale bez utraty jakości i odcinania jakichkolwiek informacji. Niestety, to po raz kolejny dowodzi, że struktura pliku RAW jest dla fotografa niczym innym jak „czarną skrzynką”, z którą mogą pracować tylko nieliczni.

odpowiedź

Aparaty amatorskie, w tym D7100, nie obsługują nieskompresowanego formatu RAW.

odpowiedź

masz rację co do kompresji. jednak, jak podano na stronie 67 instrukcji D7100, w moim przypadku kompresja wynosi 20-40%. a mianowicie „wł.”, a nie „przed”. tych. nieskompresowany RAW musi mieć co najmniej 15,6 MP * 14 bitów / kanał * 3 kanały / 8 bajtów / bity = 81 MB. Powiedzmy, że rolki kompresji 40%: 81 * 0,4 = 32,8 MB. i to bez metadanych i podglądów. okazuje się, że to wszystko ten sam „ciemny las”.

odpowiedź

Wszystko jest naprawdę proste. Nie ma potrzeby mnożenia przez 3 kanały.

odpowiedź

Nie rozumiem, dlaczego nie trzeba mnożyć przez 3 kanały. w sumie macierz daje gamę kolorów 42 bity (tj. 14 bitów na kanał). 42 bity to 6 bajtów. tych. digitalizacja jednego piksela (RGB) zajmuje 6 bajtów. tych. dla 15,6 megapiksela potrzeba 93,6 MB.

odpowiedź

Dmitry, nie przeczytałeś dokładnie tego artykułu lub w ogóle go nie przeczytałeś. Na matrycy 15,6, nie pełnokolorowych megapikseli, ale jednokolorowych. Nie ma więc potrzeby mnożenia.

odpowiedź

Wygląda na to, że złapałem sztuczkę z manipulowaniem danymi z matrycy. Jeśli jeden piksel to RGB. Który z dwóch fizycznych pikseli (RGGB + RGBB) może faktycznie uzyskać trzy piksele. ze względu na „środki” sąsiednich komórek (pierwsza i trzecia komórka to niezależne oddzielne komórki, ale druga to druga połowa pierwszej i pierwsza połowa drugiej). do takiego modelu fizycznych pikseli potrzeba o połowę mniej. ponadto ta sama metoda dotyczy poziomego i pionowego przejścia ramy. dlatego fizycznie wystarczy mieć 4 razy mniej pikseli. wtedy mój 15,6 MP zamienia się w 3,9 MP. a to jest 3,9 megapiksela * 42 bity / piksel / 8 bitów / bajt = 20,5 MB. Jest to wyraźnie zbliżone do tego, co mamy. + metadane + podgląd.

odpowiedź

Aby dodatkowo wykluczyć dyskusje na temat piksela na matrycy, czy to trzy kolory, czy jeden, Nikon zadał pytanie do działu pomocy:

Dmitro Tishchenko: Dzień dobry, Eleno! Interesuje mnie nieco dziwne pytanie dotyczące matrycy D7100.

Dmitro Tishchenko: Według instrukcji obsługi jego rozmiar to 24 megapiksele. Pytanie brzmi: co producent rozumie przez piksel? Czy w tym przypadku piksel jest pełnoprawną komórką matrycy (RGGB) czy oddzielnym kolorem (RGGB=3 piksele)?

Elena: pełnoprawna komórka”

Oznacza to, że jeden piksel to pełnokolorowy trójkolorowy piksel.

odpowiedź

„Oznacza to, że jeden piksel to pełnokolorowy trójkolorowy piksel” - to bzdura, osoba, która odpowiedziała, wyraźnie nie jest w temacie. Przeczytaj przynajmniej Wikipedię, zanim zadasz takie pytania, a tym bardziej uwierz w takie odpowiedzi. Wszystko od dawna było wielokrotnie opisywane i malowane.

W komentarzach wskoczył program RawDigger - to ona może zakończyć dyskusję na temat jednego lub trzech kolorów. Otwórz dowolny plik RAW, wejdź do ustawień, odznacz 2x2 i spójrz w trybie kompozytowym RAW. To właśnie zobaczyła matryca, bez debayeryzacji; Po powiększeniu tablica Bayera jest wyraźnie widoczna.

odpowiedź

To jest odpowiedź wsparcia. Zadałem im również pytanie w poszukiwaniu własnej odpowiedzi dotyczącej oczywistej rozbieżności w ilości otrzymanych danych. odpowiedź sprowadzała się do bliskości algorytmów przetwarzania danych. nieco wyżej zasugerowałem, że końcowe piksele można uzyskać przy znacznie mniejszej objętości komórek początkowych filtra Baera (nikt nie zabrania producentom maritza o tym nie mówić - nadal interesuje nas ostateczny rozmiar matrycy w pikseli (RGB)). z RawDiggerem postaram się dodatkowo wykonać wskazaną sztuczkę (choć wczoraj studiowałem szczegółowe metadane jednego z RAVów. Mówiło się też o pikselach i odpowiadały one rozdzielczości finalnego obrazu, lub też trzeba podzielić rozdzielczość obrazu rzeczywistego o 3). Zastanawiam się, czy program może pokazać mi całkowitą liczbę komórek, które składają się na kolor.

http://ru.wikipedia.org/wiki/%D0%9F%D0%B8%D0%BA%D1%81%D0%B5%D0%BB%D1%8C - daje odpowiedź, że jest to kolor.

http://ru.wikipedia.org/wiki/%D4%E8%EB%FC%F2%F0_%C1%E0%E9%E5%F0%E0 - mówimy nie o pikselach, ale o elementach (filtrach).

odpowiedź

Po wyłączeniu debayeryzacji RawDigger pokaże tylko to, co odbiera matryca (swoją drogą, można tam włączyć wyświetlanie nieefektywnych pikseli, mój Canon 350D ma czarny pasek po lewej i na górze). Możesz powiększyć obraz, przejść do ustawień i zaznaczyć pole 2x2, wyraźnie zobaczysz jak działa debayeryzacja. Rozdzielczość obrazu nie zmienia się, kolory pikseli zmieniają się z jednokolorowego na pełnokolorowy.

Zgodnie z linkiem istnieje takie „Pixel jest również błędnie nazywany elementem matrycy światłoczułej (sensel - z elementu czujnika)”

Ale liczba zmysłów nie powie nic zwykłym śmiertelnikom (ten artykuł jest tego dowodem - nie wszyscy rozumieli znaczenie), dlatego nazywa się je megapikselami, w oczekiwaniu, że użytkownicy będą w stanie zrozumieć, jaką rozdzielczość będzie miało zdjęcie ( cała ta kuchnia z debayerization 99% fotografów to nie obchodzi).

odpowiedź

RawDigger - próbował bardziej szczegółowo go przestudiować. I zorientowaliśmy się dalej. Tak, tak naprawdę na matrycy mówimy o subpikselach (każdy składowy koloru osobno). Dostałem im wymagane 15,6 megapiksela. Tych. 15,6 megasubpikseli * 14 bitów / subpiksel + częściowa kompresja bezstratna (o 20-40%) = 18,7-24,9 MB + 90-95 kB podgląd + metadane. co jest bardzo bliskie prawdy. ALE! Po przekonwertowaniu do tego samego TIFF bez zapisywania kanałów kolorów otrzymujemy ten sam 15,6 MP, ale po debayeryzacji. ALE! Macierz Bayer pozwala na bezpieczną i uczciwą interpolację prawie tych samych 15,6 megapikseli. W jaki sposób?!

Fragment filtra Bayera:

RRRRRR…

GBGBGB…

RRRRRR…

GBGBGB…

...

Tworzy piksele (RGB) z subpikseli (najprostsza i oczywiście głupia opcja):

RG+GR+RG

GB GB GB

GB + GB + GB

RG GR RG

RG+GR+RG

GB GB GB

tych. z tablicy 4x4 ma 9 pełnoprawnych „uczciwych” pikseli.

w celu skompensowania brakujących wierszy są dodatkowe piksele. Więc to wygląda na prawdę?

odpowiedź

przeczytaj moją odpowiedź poniżej!

Moim zdaniem UCZCIWY piksel to składowe koloru, które NIE UCZESTNICZĄ w żadnych INNYCH pikselach!

A tutaj jesteśmy po prostu oszukiwani! Interpolacja czystej wody.

odpowiedź

IMHO, jakoś wszyscy zafiksowali się na kolorowych pikselach i przegapili jedną chwilę.

Aparat z deklarowanymi 12 megapikselami faktycznie robi 12-megapikselowy obraz czarno-biały. Debayerization to w istocie przywracanie kolorów dla XNUMX-megapikselowego obrazu. Stworzenie jednego kolorowego piksela na cztery nadal prowadziłoby do pogorszenia szczegółów obrazu.

odpowiedź

Zastanawiam się, czy jest możliwe programowe przywrócenie oryginalnego czarno-białego obrazu?

odpowiedź

RawDigger Ci pomoże

odpowiedź

Aparat z 12 Mpix nie daje czarno-białego zdjęcia na 12 Mpix, bo subpiksele są pokryte różnymi kolorowymi filtrami, wynik wygląda jak siatka i trzeba to jakoś wymieszać (nie pomoże skorygowanie jasności kanałów, każdy filtr koloru zmienia jasność różnych odcieni), to znaczy, że debayeryzacja jest nadal potrzebna. I w końcu trzeba pogodzić się z hałasem (konsekwencje debayeryzacji). Czemu? Ponieważ jest zmiana. W tym momencie kręciliśmy czerwonym filtrem, a z przesunięciem w prawo - zielonym. Ale to są różne punkty obrazu. Łącząc je albo tracimy rozdzielczość, albo wprowadzamy szum.

Są eksperymentatorzy, którzy usunęli kolorowe filtry z matrycy iw ten sposób uzyskali NAPRAWDĘ czarno-białe zdjęcia. Google: Zdrapanie warstwy macierzy filtrów kolorów z czujnika DSLR w celu uzyskania ostrzejszych zdjęć czarno-białych. Po takiej manipulacji debayeryzacja nie jest już potrzebna. Możesz zrobić to samemu.

odpowiedź

A mój nie! Mam 600d - 18.1 megapikseli i jak 17.8 megapikseli rzeczywistych.

Wyobraź sobie, że obiektyw jest tak skupiony, że ziarna obrazu mieszczą się w rozmiarze jednego subpiksela.

I dostałby się w kadr na tle nieba - drut.

szła czarną plamą wzdłuż jednego rzędu subpikseli. przy debacie otrzymujemy gradient 4 pikseli, który płynnie przechodzi od koloru nieba do połowy jasności koloru tego nieba iz powrotem do koloru nieba. ale nigdy nie otrzymalibyśmy czarnego piksela, ponieważ każdy piksel debay ma parę czarnych 100% i parę jasnych 100%.

przy debacie z krokiem +2, czyli pikselizacji bez nałożenia dwóch subpikseli z poprzedniego kwadratu na nowy, otrzymalibyśmy piksel o ścisłym, nawet 75% zacienionym, którego sąsiadami są kolor nieba i jest on o 75% ciemniejszy niż sąsiedzi. To jest w idealnym przypadku, ale jak wiadomo, nie ma tak ostrych obiektywów, a zwykły obiektyw wieloryba przy przysłonie f11 może pokryć maksymalną ostrością tylko 2.5 subpiksela. tutaj przy debacie o 17 megapikseli otrzymujemy jeszcze bardziej rozmazany gradient. Ale jeśli potkniemy się o 4.5 megapiksela, otrzymamy 100% czarny piksel w miejscu, w którym przechodzi przewód i 100% kolor otaczającego nieba. Mamy zwykłe przybliżenie liniowe. gdy liczba rzeczywistych pikseli poziomo i pionowo jest podwojona, a brakujące są uzyskiwane po prostu przez interpolację. Problem komplikuje fakt, że nie udało mi się osiągnąć 4.5 megapiksela w Photoshopie, ale z wyraźnie zaznaczonym drutem w obrazie!

Dlatego pytanie brzmi – nikt nie natknął się na programy, które potrafią zrobić tiff z rzeczywistymi 4.5 pikselami z rav, które nie mają między sobą wspólnych subpikseli?

odpowiedź

Właściwie piksel matrycowy zawsze oznaczał grupę wrażliwych elementów, z których powstaje ostateczny piksel. Nawiasem mówiąc, końcowy piksel jest również wyświetlany na ekranie nie z jedną kropką, ale z tą samą grupą wielokolorowych kropek

odpowiedź

Tak, ale jeśli monitor ma 1024*720 pikseli, to wszyscy rozumieją, że za wyświetlanie odpowiadają komponenty 1024*720*3RGB (czyli z triadą na prawdziwy piksel), ale tutaj sytuacja jest inna.

odpowiedź

co innego? istota jest taka sama, aby stworzyć obraz, który odpowiada zadeklarowanym pikselom. A tak przy okazji, nie zawsze w monitorze 3RGB

odpowiedź

Esencję najlepiej ilustruje obraz przedstawiony w artykule. https://radojuva.com.ua/wp-content/uploads/2013/08/native-pixels-and-sub-piexels.jpg, a także sam artykuł, który miło by było przeczytać. Monitor może nie zawsze ma 3RGB, ale wśród przytłaczającej liczby matryc używany jest wzór Bayera.

odpowiedź

W matrycy Bayer RGBG jest jeszcze coś podstępnego: skoro w Bayerze liczba zielonych pikseli jest dwa razy większa od pozostałych, to właśnie zielony kanał ma najwyższą czułość, najszerszy DD i najniższy poziom szumów. Stwarza to pewne problemy z dokładnością pomiaru, które czasem można rozwiązać za pomocą trudnego sposobu ręcznego ustawienia BB, biorąc pod uwagę różnicę w czułości Bayera na kanał – tzw. UniWB

W ogóle szkoda, że producenci CPC zrezygnowali z matrycy RGBW: https://ru.wikipedia.org/wiki/RGBW , gdzie jeden piksel jest w ogóle bez filtra, czyli „biały”. Taka matryca utworzyła oczywiście jaśniejsze - „filmowe” kolory, ale przy pomiarze ekspozycji, czułości, szumie i DD byłoby znacznie lepiej.

odpowiedź